Découvrez nos univers de spécialisation

Vous avez, ou souhaitez, vous lancer dans une activité de Vàd ?

Santé bio et santé sénior

138 fichiers d'acheteurs avérés disponibles

Equipement de la maison

190 fichiers d'acheteurs avérés disponibles

Familles actives

66 fichiers d'acheteurs avérés disponibles

Vins & Gastronomie

58 fichiers d'acheteurs avérés disponibles

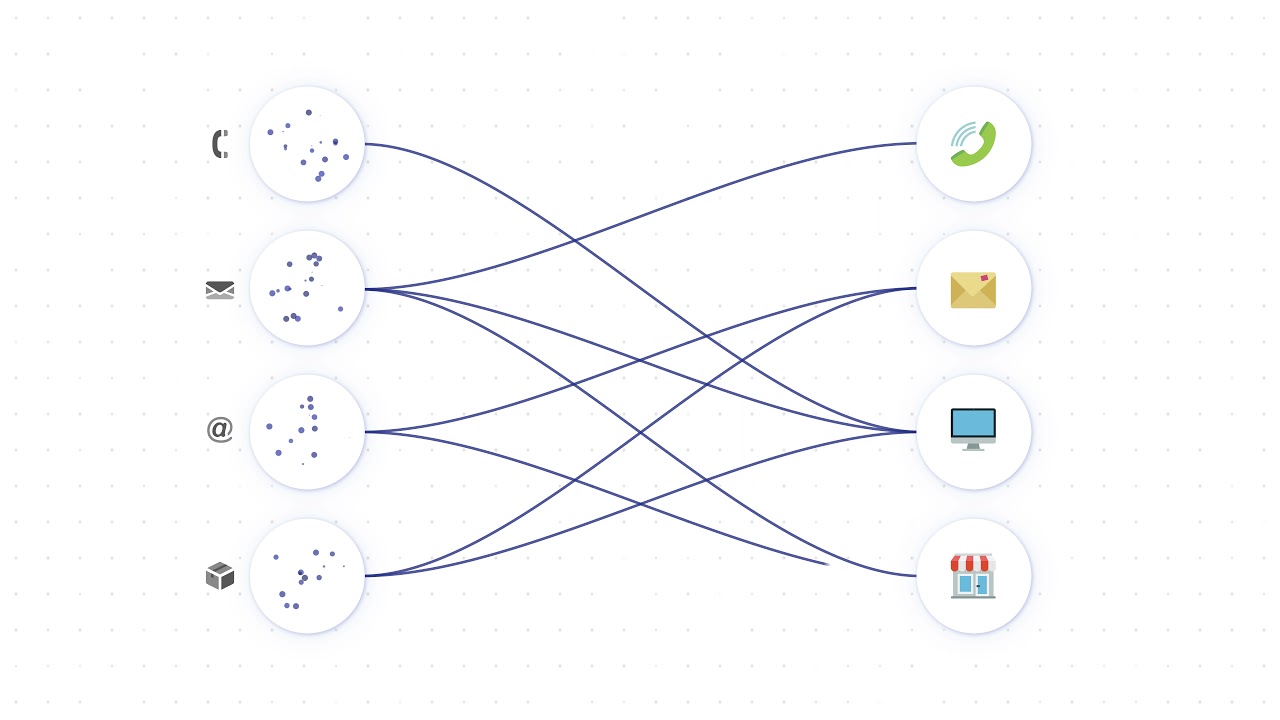

Spécialiste de la data de prospection

Notre expertise en données de prospection multicanal nous permet de vous proposer les meilleures données et les fichiers adaptés à vos problématiques et à vos cibles. Nous sommes à même de vous fournir de la data hyper-ciblée avec des comportements d’achat avérés et datés et cela sur tous les canaux.

La data au cœur de la relation client : prospecter et fidéliser.

Connaître ses clients est primordial avant de mener des campagnes d’acquisition. Notre connaissance client et notre expertise du marché de la vente à distance permettent à nos techniciens spécialisés, de nettoyer, d’enrichir et de manager les données afin d’en tirer le maximum de potentiel. Nos modèles de scores peuvent également s’appliquer à vos campagnes de fidélisation grâce à une stratégie de segmentation intelligente.

Nouveaux fichiers & Asiles-colis.

4 nouveaux fichiers disponiblesNous disposons, chez ITL d’une large base de données de fichiers de prospection BTC et BTB. Nous sommes spécialisés dans les univers de la gastronomie, de la santé sénior, santé beauté bio, de la maison, et de la femme active. A titre d’exemple, nous hébergeons plus de 10 millions d’adresses postales ultra qualifiées et 35 millions d'emails

Actualités, dossiers & lettres.

Conso.fr

Conso.fr, notre nouvelle vitrine en ligne qui met en avant vos offres et vos produits

ITL à nouveau certifié ISO 9001

Engagé depuis 2014 dans le management de la qualité, nous sommes heureux de vous informer qu’ITL a été certifié ISO 9001 pour la dixième année consécutive....

Enrichir sa base de données clients

Vous avez acquis vos données au fil du temps, et souvent avec des stratégies différentes. Aujourd'hui, vous aimeriez les utiliser dans le cadre d'un marketing p...

ÉTUDE DE CAS : Test print to web Caviar de Neuvic

Caviar De Neuvic est un producteur de caviar français établi en Dordogne. Jusqu’à présent la dynamisation de l’activité e-commerce a été exclusivement assurée p...

ITL édite un livre blanc sur la VAD de vins

Aujourd'hui plus que jamais, le consommateur recherche une proximité avec le producteur. La vente à Distance ( VAD) par les techniques classiques du papier deme...

Les statistiques fichiers de vos mailings déposés en 2020 sont fausses

En fait, les taux de commande de vos mailings sont bien plus élevés que ce que vous pensez. Ou du moins que ce que disent vos propres chiffres. C’est le constat...

ITL commercialise sa méga base propriétaires de piscines

Fort de son expérience forgée depuis plus de 35 ans dans l’univers de l’habitat, notre équipe de dataminer a mis au point une méga bases de propriétaires de pis...

Qui sommes-nous ?

J'ai besoin de vous connaître.

Les équipes d'ITL, ITL Atlantic et Dafi (Manquent Emmanuel (Dafi), Blandine ITL Atlantic et Maryse (Dafi)

Vous n’avez pas le temps ?

Nous vous recontactons.

En renseignant votre numéro de téléphone, vous acceptez d'être recontacté par ITL et vous reconnaissez avoir pris connaissance de notre politique de confidentialité.